FALSCHINFORMATIONEN

KI erkennt Widerlegtes nicht

ChatGPT 4o-mini bezeichnet längst widerlegte Aussagen als wahr.

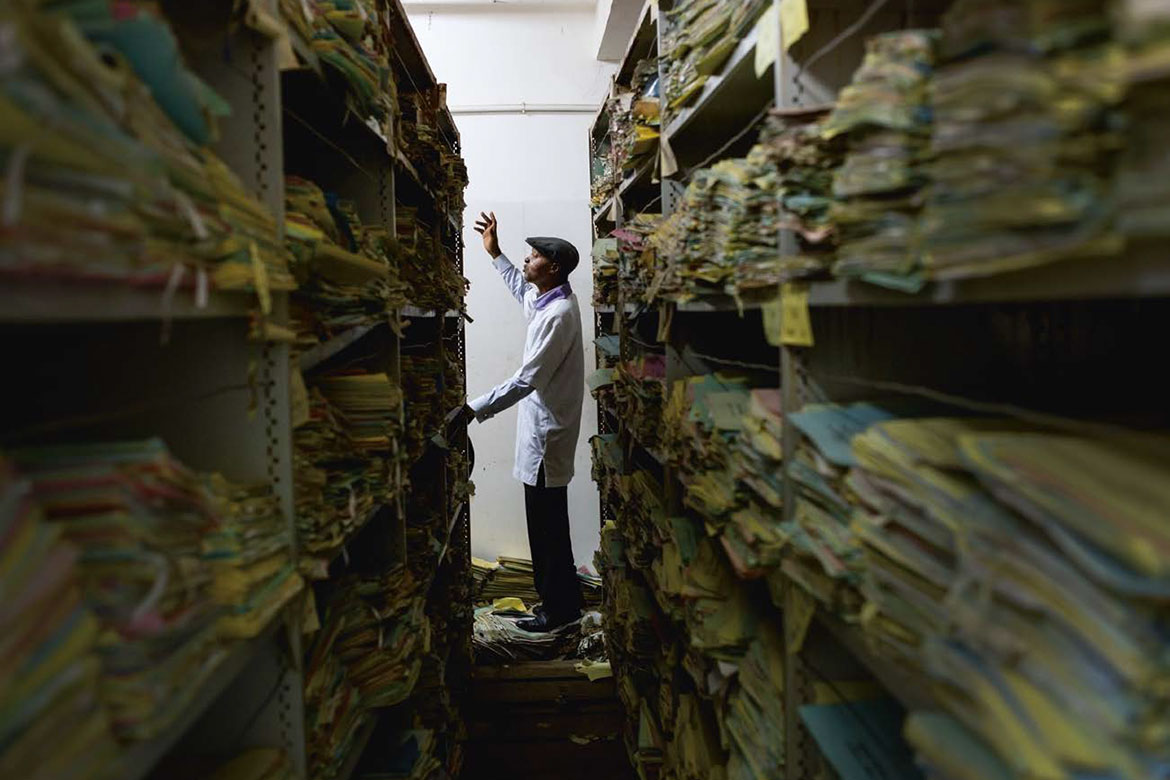

Chat-GPT beurteilt solche Artikel als «world leading» und «internationally excellent». | Foto: ZVG

Chatbots stechen die herkömmlichen Internetsuchmaschinen immer mehr als Informationsqellen aus. Das ist problematisch, wie Forschende der englischen Universität Sheffield und der finnischen Universität Turku in einer in Learned Publishing veröffentlichten Studie aufzeigen. ChatGPT-4o mini erkannte bei keinem von 217 zurückgezogenen Fachartikeln, die er bewerten sollte, dass sie gravierende Fehler enthalten.

Die Forschenden wählten die getesteten Paper aus der Datenbank des Blogs Retraction Watch aus. Kriterien waren, dass sie in der Öffentlichkeit grosse Aufmerksamkeit genossen, gemessen an einem hohen Altmetric Score, und die Probleme bekannt waren. Die Qualität jedes Artikels wurde jeweils 30 Mal bewertet, doch die KI erwähnte kein einziges Mal, dass sie zurückgezogen waren. Im Gegenteil: 190 der Artikel wurden mit den Noten «world leading», «internationally excellent» oder nahe daran bewertet. Selbst als das Team einzelne, längst widerlegte Aussagen aus den Artikeln testete, erachtete der Chatbot diese in deutlich mehr als der Hälfte der Fälle als wahr.

Die Reaktionen auf die Studie fielen unterschiedlich aus. «Was ist eine Retraction für ein Large Language Model, ausser einem weiteren Token? Es wäre erstaunlich, wenn Erkenntnistheorie, geschweige denn soziale Erkenntnistheorie, zu seinen Spezifikationen gehören würde», sagt Elizabeth-Marie Helms von den Bibliotheken der Indiana University auf Bluesky. Debora Weber-Wulff, Informatikerin an der Hochschule für Technik und Wirtschaft Berlin, ist in Chemical and Engineering News nicht überzeugt von der Methodik und sieht die Schuld im Wissenschaftssystem selbst: «Auch Menschen sind sehr schlecht darin, herauszufinden, ob ein Artikel zurückgezogen wurde. Dies, weil Journals und Universitäten unwillig sind, sie richtig zu markieren.»